如果說2016年擊敗李世石的使用強化學習模型的AlphaGO(阿爾法圍棋)沒有給你留下深刻影響,那么基於大語言模型技術的ChatGPT應足以讓你感慨,AI的腳步越來越貼近我們的生活,我們對於AI所帶來的變動感知越來越清晰。

從廣義上講,只要能夠運行人工智能算法的芯片都叫芯片。而從AI運算過程看,其貫穿了雲-邊-端,因此又可分爲雲端芯片、邊端芯片、終端芯片,外加一個適配海量數據的存儲芯片。具體到技術架構層面,AI芯片主要分爲圖形處理器(GPU)、現場可編程門陣列(FPGA)、專用集成電路(ASIC)、中央處理器(CPU)等類腦芯片四大類。

當下正值國內外大模型爆發期,算力缺口出現,GPU芯片引起市場關注。

01

GPU:每家都需要,每家都在搶

當下大部分的現象級AI產品如Chat GPT背後的算力支撐主要來自GPU或CPU+FPGA。其中GPU的火熱遠超CPU。“GPU專爲加速計算和生成式AI而設計,未來你需要更少的CPU,GPU的連接將會更加普遍。”英偉達CEO黃仁勳表示。

大模型對於GPU的性能和數量要求都很高,據前人工智能NLP企業首席科學家、千芯科技董事長陳巍測算,國內如果想要直接訓練出一個GPT-3級別的大模型,最少需要3000到5000枚A100級別的AI芯片。以保守情況估計,目前國內A100級別的AI芯片缺口在30萬枚左右。

AI大火以後,英偉達旗下A100、H100、A800和H800等高性能GPU芯片應聲漲價,一度被調侃爲新一代理財產品。國內外消息顯示,其旗艦級芯片H1004月中旬在海外電商平台就已炒到超4萬美元,甚至有賣家標價6.5萬美元。英偉達的中國特供版A800和H800芯片也不例外,近日一位經銷商表示,目前其手中NVIDIA A800的售價已較一周上漲約30%,服務器現貨則由120多萬元一台漲至接近140萬元。

那個愛穿皮衣的男人最先嘗到了AI紅利。在上市14年之後,英偉達成功躋身萬億美元市值俱樂部,而實現這一目標,硅谷巨頭們諸如蘋果用了37年、微軟用了33年、亞馬遜用了21年,特斯拉跑得最快,只用了11年。

不過,在GPU爆火大潮下,也難以逃脫如2020年車規芯片短缺的境遇。GPU的供應短缺到了何種程度呢?當下即使如OpenAI,也無法獲得足夠的GPU,馬斯克表示,這嚴重阻礙了其近期路线圖。

業界消息顯示,GPU缺口還在加速擴大。此前已有媒體報道今年擁有雲端相關業務的企業,大多都向英偉達採購了大量GPU,目前該公司訂單已排至2024年。

02

產能跟不上,先進封裝是關鍵

GPU芯片供應短缺的背後,與先進封裝產能供應不足息息相關。從從供應鏈角度看,先進封裝一定程度上影響着AI芯片的放量速度。

行業消息顯示,目前NVIDIA A100、H100 GPU完全由台積電代工生產,搭載第三代HBM(高帶寬內存),並使用台積電CoWoS先進封裝技術,此外博通、AMD等芯片公司也在爭搶台積電CoWoS產能,導致台積電產能壓力大增。

面對先進封裝CoWoS產能爆滿,近日在2023年第二季度线上法說會上,台積電表示,到2024年CoWos產能將擴充2倍以上。台積電總裁魏哲家表示,與AI芯片相關的一些高級封裝可能在2024年底之前仍然供應緊張。因此,需求可能在相當長的時間內持續超過供應,因爲AMD和英偉達將無法擴大生產至某個點,盡管某些4nm和5nm的產能是可用的。

近期,媒體報道爲滿足市場需求,台積電已向Disco、Apic Yamada及台廠辛耘、弘塑等先進封裝設備供應商啓動第三波追單。

03

響應需求,HBM加速开發

由於目前幾乎所有的HBM系統都封裝在CoWos上,HBM存儲本質上也屬於先進封裝的一部分。

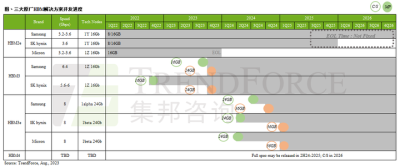

根據TrendForce集邦咨詢調查顯示,2023年HBM(High Bandwidth Memory)市場主流爲HBM2e,包含NVIDIA A100/A800、AMD MI200以及多數CSPs自研加速芯片皆以此規格設計。同時,爲順應AI加速器芯片需求演進,各原廠計劃於2024年推出新產品HBM3e,預期HBM3與HBM3e將成爲明年市場主流。

TrendForce集邦咨詢特別表示,目前市場所稱的HBM3實際需細分爲兩種速度討論,其一,5.6~6.4Gbps的HBM3;其二,8Gbps的HBM3e,別名HBM3P、HBM3A、HBM3+、HBM3 Gen2皆屬此類。

目前三大原廠HBM發展進度如下,兩大韓廠SK海力士(SK hynix)、三星(Samsung)先從HBM3开發,代表產品爲NVIDIA H100/H800以及AMD的MI300系列,兩大韓廠預計於2024年第一季送樣HBM3e;美系原廠美光(Micron)則選擇跳過HBM3,直接开發HBM3e。

HBM3e將由24Gb mono die堆棧,在8層(8Hi)的基礎下,單顆HBM3e容量將一口氣提升至24GB,此將導入在2025年NVIDIA推出的GB100上,故三大原廠預計要在2024年第一季推出HBM3e樣品,以期在明年下半年進入量產。

本文作者可以追加內容哦 !

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:AI狂潮,GPU短缺嚴重,先進封裝火力全开!

地址:https://www.twetclubs.com/post/17356.html